Dałeś programistom Copilota i oczekujesz przyspieszenia developmentu? To Błąd!

Wdrożenie GitHub Copilot czy podobnych asystentów obecnie jest niemal standardem. Potwierdzają to dane z rynku: na początku 2025 roku z GitHub Copilot korzystało już ponad 15 milionów programistów (co stanowi 400% wzrost w ciągu zaledwie 12 miesięcy). Efekt? Organizacje oczekują znaczącej poprawy wydajności i szybkiego ROI na poziomie całych projektów.

Tu jednak pojawia się problem. Otóż okazuje się, że wzrost produktywności na poziomie pojedynczego developera – co sprowadza się do szybszego pisania kodu – automatycznie nie przekłada się na przyspieszenie velocity całego zespołu.

I tu dochodzimy do sedna sprawy. Problem nie leży w samych narzędziach, a w braku metodologii ich wdrażania. Wprowadzanie AI w sposób chaotyczny, bez systemowego podejścia, prowadzi do narastania długu technologicznego. W rezultacie w wielu przypadkach nie dochodzi do oczekiwanego przyspieszenia, a jedynie do inaczej zarządzanego chaosu.

Wszystko to można także wyczytać z danych rynkowych. Badania MIT Media Lab potwierdzają, że obecnie jedynie 5 proc. projektów AI przynosi realną wartość! Jak widać, sytuacja jest naprawdę poważna, dlatego w tym wpisie blogowym poszukamy głównego winowajcę takiego stanu rzeczy i zastanowimy się, jak rzeczywiście możemy osiągnąć przyspieszenie.

Kluczowe informacje

- Firmy utknęły w fazie „Entuzjasty” (średni wskaźnik gotowości to zaledwie 2.47/4), co oznacza oddolne stosowanie AI bez strategii.

- Narzędzia AI przyspieszają pisanie kodu (nawet o 55%), ale tworzą nowe, systemowe wąskie gardło w postaci przeciążenia senior developerów podczas Code Review.

- Generatywna AI wprowadza nowe, trudne do zmierzenia kategorie długu technologicznego, jak „dług związany z promptami” (Prompt Drift) czy „dług wyjaśnialności”.

- Przejście od chaosu do ustrukturyzowanej metodyki pozwala realnie skrócić czas realizacji zadań 3-5x i zredukować błędy „na produkcji” o 30-50%.

Dlaczego wdrożenia AI generują chaos zamiast zysków?

Zanim przejdziemy do rozwiązań, musimy precyzyjnie zdiagnozować, dlaczego oddolne, niekontrolowane stosowanie AI jest nieefektywne i ryzykowne.

Luka w ROI: problem z ROI

Zacznijmy od podstawowego problemu, jakim jest rozbieżność między obietnicami a rzeczywistym zwrotem z inwestycji (ROI). Rynek AI obiecuje wiele, ale tak naprawdę brakuje twardych danych z ukończonych z sukcesem wdrożeń.

Wiele osób postrzega tę “lukę” jako prostą różnicę w oczekiwaniach – na przykład spodziewano się 15% ROI, a uzyskano 5%. Jednak, jak wskazują analitycy z MIT Sloan, problem jest znacznie głębszy. Prawdziwa luka polega na tym, że branża oczekiwała zysków, podczas gdy większość organizacji (poza gigantami technologicznymi) wciąż jest na etapie kosztownych eksperymentów i pilotaży.

W efekcie czego eksperci zaczęli dyskutować na nieco inny temat. Zamiast mówić o „zrealizowanym ROI”, firmy skupiają się na „problemach z wdrożeniem” i „wskaźniku porażek projektów pilotażowych”. Prowadzi to do sytuacji, w której wiele inicjatyw jest porzucanych, zanim ROI zdąży zostać w ogóle obliczone.

Presja na wdrożenia ze strony decydentów

Problem chaosu pogłębia ogromna presja na wyniki. Globalne badanie EY CEO Outlook Pulse Survey 2024 ujawnia, że aż 76% dyrektorów generalnych oczekuje, że AI przełoży się na konkretne usprawnienia. Presja jednak prowadzi do chaotycznych wdrożeń, ponieważ jest to najszybszy sposób na wykazanie jakichkolwiek działań.

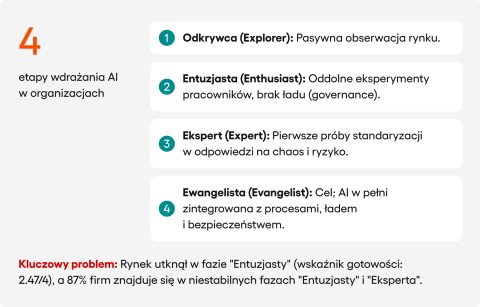

Dowodów na skalę tego chaosu dostarcza raport AI Adoption Index 2.0, który analizuje poziom zaawansowania wdrożeń w firmach, dzieląc je na cztery etapy. Wyróżniamy tutuaj: Odkrywcę, Entuzjastę, Experta oraz Ewangelistę.

Kluczowym wskaźnikiem jest gotowość rynku, która w 2024 roku wynosiła zaledwie 2.47 w 4-stopniowej skali. Oznacza to, że przeciętna firma znajdowała się wtedy w fazie „Entuzjasty”. Co więcej, aż 87% przedsiębiorstw umiejscowiono w niestabilnych fazach „Entuzjasty” i „Eksperta”. Można to zdefiniować jako sytuacja, w której oddolne eksperymenty już trwają, ale brakuje centralnej kontroli nad ryzykiem i kosztami.

I to jest właśnie ta luka w ładzie (governance gap), przed którą ostrzegają analitycy z McKinsey. Wskazują, że podejście „ad-hoc” z definicji pomija elementy ładu, takie jak zdefiniowanie zasad tagowania wrażliwych danych, ustawienie kontroli dostępu czy wdrożenie ochrony danych wychodzących.

Nowe kategorie długu technologicznego generowane przez AI

Badania potwierdzają, że AI wprowadza całkowicie nowe kategorie długu, które są niewidzialne dla tradycyjnych narzędzi analitycznych.

- Dług związany z promptami (Prompt Related TD) występuje, gdy logika biznesowa, zamiast znajdować się w kodzie, staje się częścią niestrukturyzowanego tekstu (promptów). Traci się nad nią kontrolę (wersjonowanie, testowanie). Drobna zmiana w prompcie („Prompt Drift”) może niepostrzeżenie zaburzyć kluczową funkcjonalność.

- Dług związany z modelem i danymi (Model & Data Debt) powoduje, że system staje się niestabilny. Jego zachowanie może się zmienić nie przez modyfikację kodu, ale przez aktualizację API zewnętrznego dostawcy („Model Drift”). Aplikacja przestaje działać, mimo że zespół developerski nie modyfikował kodu.

- Dług wyjaśnialności (Explainability Debt) to droga do tworzenia systemów typu „czarna skrzynka”, których nie da się efektywnie debugować. Jeśli AI podejmie błędną decyzję w systemie finansowym lub medycznym, a my nie możemy wyjaśnić tej decyzji, organizacja podejmuje ryzyko biznesowe i prawne.

Przeciążenie senior developerów

W tym miejscu dochodzimy do sedna paradoksu. Otóż lokalne przyspieszenie jeśli chodzi o pisanie kodu stworzyło nowe, wąskie gardło w postaci przeciążenia developerów na stanowiskach seniorskich.

Tak, obciążenie seniora nie zmalało. Zmieniło jedynie swój charakter na wysoce analityczny, przy jednoczesnym wzroście wolumenu pracy. Obecnie ten szybciej wygenerowany kod trafia do seniorów, przez co ich praca fundamentalnie się zmieniła. Z jednej strony, AI odfiltrowała proste błędy składni. Z drugiej jednak strony, senior musi teraz weryfikować więcej kodu, sprawdzając jego zgodność z architekturą, poprawność interpretacji logiki biznesowej oraz ukryte konsekwencje dla skalowalności.

Zamiast pomagać, AI wdrażane w sposób chaotyczny często sprawia, że najcenniejsi ludzie w zespole pełnią funkcję “ludzkiego debuggera” dla kodu. Dlatego, mimo że badania GitHuba potwierdzają przyspieszenie zadań nawet o 55%, wąskie gardło nie zniknęło. Jak zauważają analitycy, pisanie kodu rzadko kiedy jest prawdziwym wąskim gardłem w dobrze prowadzonym projekcie. Po prostu przeniosło się w inne miejsce i stało się trudniejsze do pokonania.

„Shadow AI” a zgodność z RODO i DORA

Na koniec poruszymy najważniejszą kwestię, czyli bezpieczeństwo.

- 99% organizacji, wg Varonis, posiada wrażliwe dane (np. kod źródłowy, dane klientów), które są narażone na nieautoryzowany dostęp przez narzędzia AI.

- 20% firm zgłosiło już naruszenie bezpieczeństwa spowodowane bezpośrednio przez „Shadow AI”, co zwiększyło średni koszt incydentu o 670 000 dolarów.

Organizacje zajmujące się standardami bezpieczeństwa, takie jak OWASP, musiały stworzyć nową listę Top 10 dla LLM. Znalazły się na niej nowe wektory ataku, jak „Prompt Injection” czy „Sensitive Information Disclosure” (wyciek danych wrażliwych), co stanowi bezpośrednie zagrożenie naruszenia RODO.

W sektorze finansowym (objętym regulacją DORA) sytuacja jest szczególnie poważna. Aż 80% CISO, wg Bright Defense, przyznaje, że AI pozwala hakerom generować nowe wektory ataków szybciej, niż ich organizacje są w stanie na nie odpowiednio reagować.

Nasza odpowiedź: inwestycja w autorski framework AI do SDLC

Jako partner technologiczny, nie rozliczamy się z „używania AI”, lecz z konkretnych wyników. Tymi wynikami jest dostarczanie oprogramowania klasy enterprise w ustalonym czasie.

Dlatego bardzo szybko zauważyliśmy, że wprowadzanie AI w sposób chaotyczny jest podejściem nieefektywnym. Generuje dług, ryzyko i koszty, które ostatecznie obciążają klienta i spowalniają projekt w dłuższej perspektywie.

Stanęliśmy przed wyborem. Albo akceptujemy ograniczenia narzędzi rynkowych, albo inwestujemy czas i zasoby w budowę własnej, autorskiej metodyk, która rozwiązuje zdiagnozowane problemy dotyczące m.in. kontekstu i ryzyka.

Wymagało to zmierzenia się z faktycznymi problemami w ramach naszego R&D. Musieliśmy bowiem znaleźć sposób, jak dać AI pełen kontekst projektu, jak ustrukturyzować wiedzę ekspertów w powtarzalny proces i jak zapewnić pełne bezpieczeństwo danych.

Speedflow: metodyka zrodzona z praktyki

Speedflow to nie jest kolejny plugin. To autorska metodyka, która integruje AI w proces SDLC, zamiast dodawać ją jako zewnętrzny element. System ten rozwiązuje problemy zdiagnozowane w pierwszej sekcji.

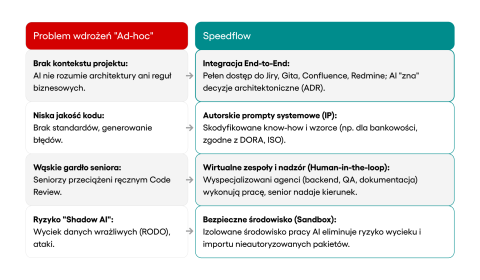

Jak rozwiązujemy problem kontekstu? Poprzez integrację end-to-end.

Speedflow jest w pełni zintegrowany z całym ekosystemem narzędziowym projektu – od Jiry i Gita, przez CI/CD i Confluence, aż po Redmine, Slacka czy Teams. To stamtąd czerpie pełną wiedzę o kodzie, architekturze (ADR), zgłoszeniach i regułach biznesowych. AI „zna” decyzję architektoniczną, ponieważ ma bezpośredni dostęp do Confluence, gdzie ten ADR rezyduje.

Jak rozwiązujemy problem jakości? Poprzez autorskie prompty systemowe (IP).

Jakość w Speedflow gwarantuje nasze unikalne, wypracowane IP. Nie jest to „prompt book”, który może stworzyć każdy zespół, ale wzorce i procesy stworzone przez naszych najlepszych architektów, którzy przez lata pracowali nad projektami dla sektora bankowego i finansowego. To skodyfikowane know-how, jak pisać kod, który jest bezpieczny, audytowalny i zgodny z rygorystycznymi regulacjami (jak GDPR, ISO 270001 czy DORA). Kiedy agent AI w Speedflow pisze kod, używa wzorców przetestowanych w najbardziej wymagających wdrożeniach.

Jak rozwiązujemy problem „Wąskiego Gardła Seniora”? Poprzez wirtualne zespoły i nadzór (human-in-loop).

Rozwiązanie to fundamentalnie redefiniuje rolę seniora. Zamiast jednego „Copilota” generującego chaos, Speedflow tworzy Wirtualny Zespół agentów wyspecjalizowanych w konkretnych rolach, takich jak agent dewelopera back-end, specjalista ds. dokumentacji czy agent QA generujący testy. AI wykonuje najcięższą, powtarzalną pracę. Rola seniora (czyli nadzór Human-in-the-Loop) zmienia się z „recenzenta” kodu na „osobę nadającą kierunek całego projektu”. Senior gwarantuje jakość i integralność architektury, ale nie traci już czasu na poprawianie podstawowych błędów czy pisanie boilerplate’u.

Jak rozwiązujemy problem ryzyka (RODO/DORA)? Poprzez bezpieczne środowisko (sandbox) i niezależność

To jest nasza bezpośrednia odpowiedź na zagrożenie „Shadow AI” i wymogi związane z regulacjami. Cała praca agentów AI odbywa się w bezpiecznym, izolowanym środowisku (Sandbox). Takie podejście eliminuje ryzyko niekontrolowanego wycieku danych na zewnątrz oraz importowania nieautoryzowanych pakietów. Co więcej, nasza niezależność od dostawców (kompatybilność z Claude, GPT, Gemini itd.) eliminuje ryzyko vendor lock-in, dając gwarancję ciągłości działania niezależnie od polityki cenowej jednego dostawcy.

Rezultat: co to oznacza dla naszych klientów?

Inwestycja w Speedflow była środkiem do celu, którym jest dotrzymanie obietnicy dotyczącej tworzenia oprogramowania enterprise szybciej i taniej. Nasza metodyka zamienia chaos na mierzalne rezultaty.

- W miejsce ryzyka związanego z compliance, dostarczamy dokumentację gwarantującą pomyślne przejście audytu (w tym kompletne audit trails, niezbędne dla AI Act oraz DORA).

- Przeciążenie seniorów maleje, a onboarding nowych osób skraca się o 50%, ponieważ AI daje im kontekst projektu i aktywnie pilnuje standardów.

- W miejsce rosnącego długu technologicznego, obserwujemy 30-50% mniej błędów trafiających na produkcję, gdyż system pracuje na pełnym kontekście i generuje automatycznie testy.

- Zamiast stagnacji w velocity, nasza metodyka pozwala 3-5x szybciej wykonywać zadania oraz osiągnąć 1.5-2x wyższą przepustowość (throughput) zespołu.

Wnioski: AI SDLC to sprawdzony sposób na przyspieszenie developmentu

Copilot to nie strategia, to narzędzie. Poleganie wyłącznie na nim prowadzi do sytuacji, w której – mimo że kod piszemy szybciej – cały proces może zwolnić. Firmy skupiają się na optymalizacji pojedynczych zadań, przez co developerzy rzeczywiście piszą kod szybciej. Ten zysk na poziomie jednego zadania nie przekłada się jednak na systemową wydajność.

Dane, które przeanalizowaliśmy, jednoznacznie to pokazują. Zyski z szybszego pisania kodu są jednak blokowane przez trzy główne elementy w całym procesie:

Po pierwsze, przez kolejkę do recenzji, gdzie przeciążeni seniorzy mierzą się z większą objętością kodu. Do tego dochodzi debugowanie, które staje się znacznie trudniejsze z powodu nowych, niewidzialnych form długu technologicznego, jak „Prompt Drift” czy „Model Drift”. I finalnie, mamy tu też do czynienia z podwyższonym ryzykiem finansowym i prawnym, związanym z naruszeniami wynikającymi z „Shadow AI” (średnio 670 000 dolarów na incydent) oraz niezgodnością z RODO i DORA.

Jak widzimy, chaotyczne podejście „ad-hoc” po prostu nie działa. A faza „Entuzjasty”, w której tkwi dziś większość rynku, to najlepszy dowód na to, że weszliśmy w “ślepą uliczkę”.

Warto więc pamiętać, że prawdziwe przyspieszenie możemy osiągnąć jedynie wtedy, kiedy posiadamy zdolność do systemowego wdrożenia AI. Dlatego wybierając partnera do tworzenia oprogramowania należy sprawdzić, czy jego podejście do AI kończy się na zakupie licencji dla programistów, czy może opiera się na własnym, sprawdzonym frameworku AI do przyspieszenia SDLC, który faktycznie gwarantuje jakość i zgodność z regulacjami.

Artykuły na tym blogu tworzy zespół ekspertów specjalizujących się w AI, rozwoju aplikacji webowych i mobilnych, doradztwie technicznym oraz projektowaniu produktów cyfrowych. Naszym celem nie jest marketing, a dostarczanie wartościowych materiałów edukacyjnych.